Las potentes herramientas de IA al alcance de cualquiera con conexión a Internet facilitan la suplantación de la voz de alguien, aumentando la amenaza de las estafas telefónicas.

Por Matthew Wright, Catedrático de Seguridad Informática & Christopher Schwartz, Investigador Postdoctoral Asociado de Seguridad Informática, Instituto de Tecnología de Rochester

Acaba de regresar a casa tras un largo día de trabajo y está a punto de sentarse a cenar cuando, de repente, su teléfono empieza a zumbar. Al otro lado está un ser querido, tal vez un padre, un hijo o un amigo de la infancia, rogándole que le envíe dinero inmediatamente.

Usted les hace preguntas, intentando comprender. Hay algo raro en sus respuestas, que son vagas o están fuera de lugar, y a veces hay un retraso peculiar, casi como si pensaran un poco demasiado despacio. Sin embargo, usted tiene la certeza de que sin duda es su ser querido quien habla: Es su voz la que oye, y el identificador de llamadas muestra su número. Atribuyendo la extrañeza a su pánico, usted envía obedientemente el dinero a la cuenta bancaria que le facilitan.

Al día siguiente, les vuelve a llamar para asegurarse de que todo va bien. Su ser querido no tiene ni idea de lo que le está hablando. Eso es porque nunca le han llamado – le ha engañado la tecnología: un deepfake de voz. Miles de personas fueron estafadas de esta forma en 2022.

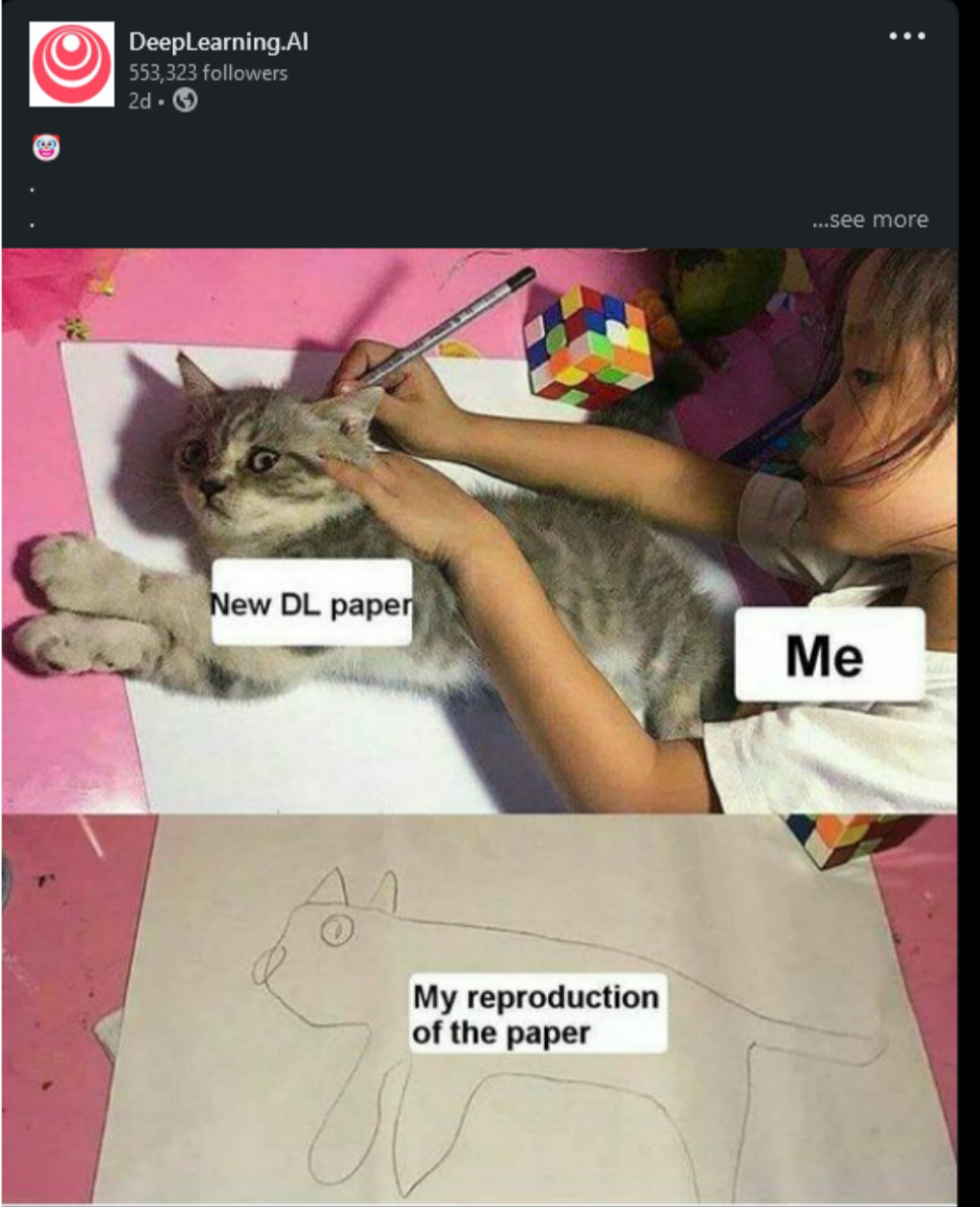

Como seguridad informática investigadores, vemos que los continuos avances en algoritmos de aprendizaje profundo, edición e ingeniería de audio y generación de voz sintética han hecho que cada vez sea más posible simular de forma convincente la voz de una persona.

Peor aún, chatbots como ChatGPT están empezando a generar scripts realistas con respuestas adaptables en tiempo real. Por combinar estas tecnologías con la generación de voz, un deepfake pasa de ser una grabación estática a un avatar vivo y realista que puede mantener de forma convincente una conversación telefónica.

Elaborar un deepfake convincente de alta calidad, ya sea de vídeo o de audio, no es lo más fácil. Requiere una gran cantidad de habilidades artísticas y técnicas, un hardware potente y una muestra bastante considerable de la voz objetivo.

Cada vez hay más servicios que ofrecen producir clones de voz de calidad moderada a alta por una tarifa, y algunas herramientas de deepfake de voz necesitan una muestra de sólo un minuto de duración, o incluso sólo unos segundos, para producir un clon de voz que podría ser lo suficientemente convincente como para engañar a alguien. Sin embargo, para convencer a un ser querido – por ejemplo, para utilizarlo en una estafa de suplantación de identidad – probablemente se necesitaría una muestra significativamente mayor.

Dicho todo esto, en la Proyecto DeFake del Instituto de Tecnología de Rochester, la Universidad de Mississippi y la Universidad Estatal de Michigan, y otros investigadores están trabajando duro para poder detectar deepfakes de vídeo y audio y limitar el daño que causan. También hay medidas sencillas y cotidianas que puede adoptar para protegerse.

Para empezar, suplantación de voz, o “vishing”, estafas como la descrita anteriormente son las más probables falsificaciones de voz que puede encontrarse en la vida cotidiana, tanto en el trabajo como en casa. En 2019, un empresa energética fue estafada por 243.000 dólares cuando unos delincuentes simularon la voz del jefe de su empresa matriz para ordenar a un empleado que transfiriera fondos a un proveedor. En 2022, la gente fue estafadas por un valor estimado de 11 millones de dólares mediante voces simuladas, incluso de conexiones personales cercanas.

¿Qué puede hacer?

Esté atento a las llamadas inesperadas, incluso de personas que conoce bien. Esto no quiere decir que tenga que programar todas las llamadas, pero ayuda al menos enviar un correo electrónico o un mensaje de texto con antelación. Además, no confíe en el identificador de llamadas, ya que también se puede falsificar. Por ejemplo, si recibe una llamada de alguien que dice representar a su banco, cuelgue y llame directamente al banco para confirmar la legitimidad de la llamada. Asegúrese de utilizar el número que tiene anotado, guardado en su lista de contactos o que puede encontrar en Google.

Además, tenga cuidado con sus datos de identificación personal, como el número de la Seguridad Social, la dirección de su domicilio, la fecha de nacimiento, el número de teléfono, el segundo nombre e incluso los nombres de sus hijos y mascotas. Los estafadores pueden utilizar esta información para hacerse pasar por usted ante bancos, agentes inmobiliarios y otros, enriqueciéndose mientras le llevan a la quiebra o destruyen su crédito.

He aquí otro consejo: conózcase a sí mismo. Concretamente, conozca sus prejuicios y vulnerabilidades intelectuales y emocionales. Este es un buen consejo de vida en general, pero es clave para protegerse de ser manipulado. Los estafadores suelen tratar de averiguar y luego aprovecharse de sus ansiedades financieras, sus apegos políticos u otras inclinaciones, sean cuales sean.

Este estado de alerta es también una defensa decente contra la desinformación mediante deepfakes de voz. Los deepfakes pueden utilizarse para aprovecharse de su sesgo de confirmacióno lo que usted se inclina a creer sobre alguien.

Si oye a una persona importante, ya sea de su comunidad o del gobierno, decir algo que le parece muy poco característico de ella o que confirma sus peores sospechas sobre ella, sería prudente que desconfiara.

Este artículo es de The Conversation, una organización independiente de noticias sin ánimo de lucro dedicada a compartir los conocimientos de expertos académicos. Más información o suscríbase a nuestro semanario Ciencia y tecnología Selecciones de los editores.